記事の要点

- 画像認識技術の進化と「意味理解」へのシフト

- 現場適用における各手法の強み・弱みの明確化と使い分け指針の提示

- マルチモーダルLLMの強みとFA領域における課題

はじめに

株式会社エスタイルのガッキーです。

私は以前勤めていた会社にて製造業の現場へ向けて、画像処理ソリューションによる課題解決の提案を行う立場に身を置いていました。そんな製造業の現場において、長らく「画像認識」が品質保証の要でした。特に外観検査や位置決めなど、製造ラインの目としての役割は極めて重要です。

しかし近年、GPT-5.1 や Gemini 3 に代表される マルチモーダルLLMの登場 により、画像の扱い方が根本から変わり始めています。

これまでの画像認識は「写っているものを判別する」ものでしたが、現在では “なぜその判断に至ったのか” まで説明できる時代に到達しつつあります。

本記事では、FA領域を前提に

- ルールベース

- ディープラーニング(CNN)

- マルチモーダルLLM

の三つの技術を 歴史 → 強み → 弱み → 実例 → 役割分担 の順に整理し、実務でどう使い分けるべきかを解説します。

注意点として、本記事は2次元画像を前提にした内容です。 また、執筆時点でリリースされている最新バージョンであるGemini 3をベースに解説します。

ファクトリーオートメーション(FA)とは?

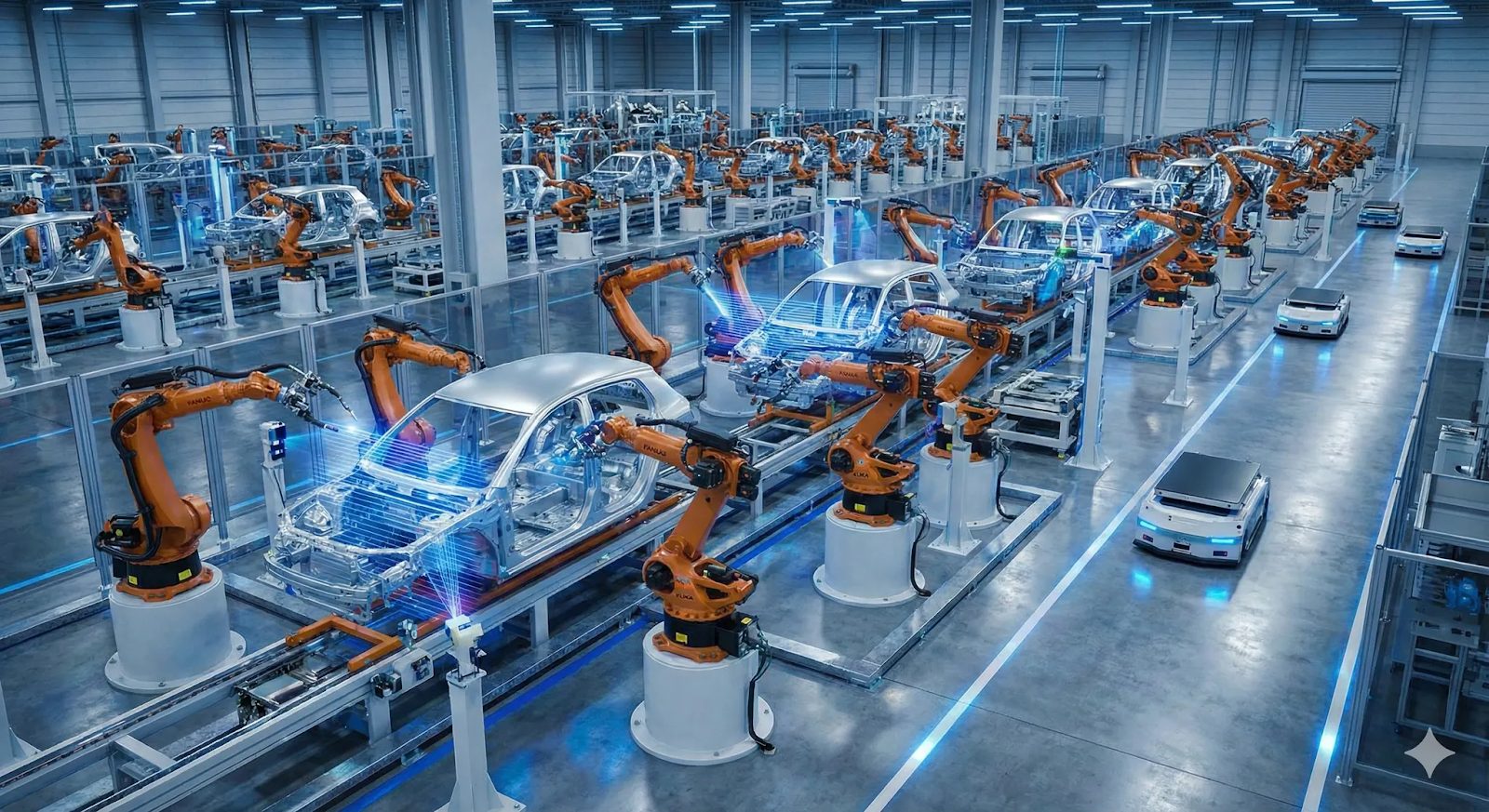

FA(Factory Automationの略)とは、工場における受注、製造、検査、出荷といった一連の工程を、人間ではなく機械(ロボット、センサー、制御システム)によって自動化する技術の総称です。

下記画像のようにロボットが自立し、動作するシステムをご想像ください。

無人化工場のイメージ図(Gemini 3 Proより作成)

特に日本の製造業では、少子高齢化による人手不足を背景に、単なる「自動化」から「知能化(AI導入)」へのシフトが急務となっています。

FAシステムの中で、画像認識は「マシンビジョン」と呼ばれ、人間の「目」の役割を果たします。

Webの画像認識(例:Googleフォトの分類)と大きく異なるのは、「物理的なアクションに直結する」点です。 具体的には、下記のような操作が求められています。

- 検査: キズ・欠品・異物の判定

- 計測: 寸法や角度をミリ単位で測る

- 位置決め: ロボットアームの座標算出

- 読取: バーコード・OCR・刻印認識

画像認識技術の変遷

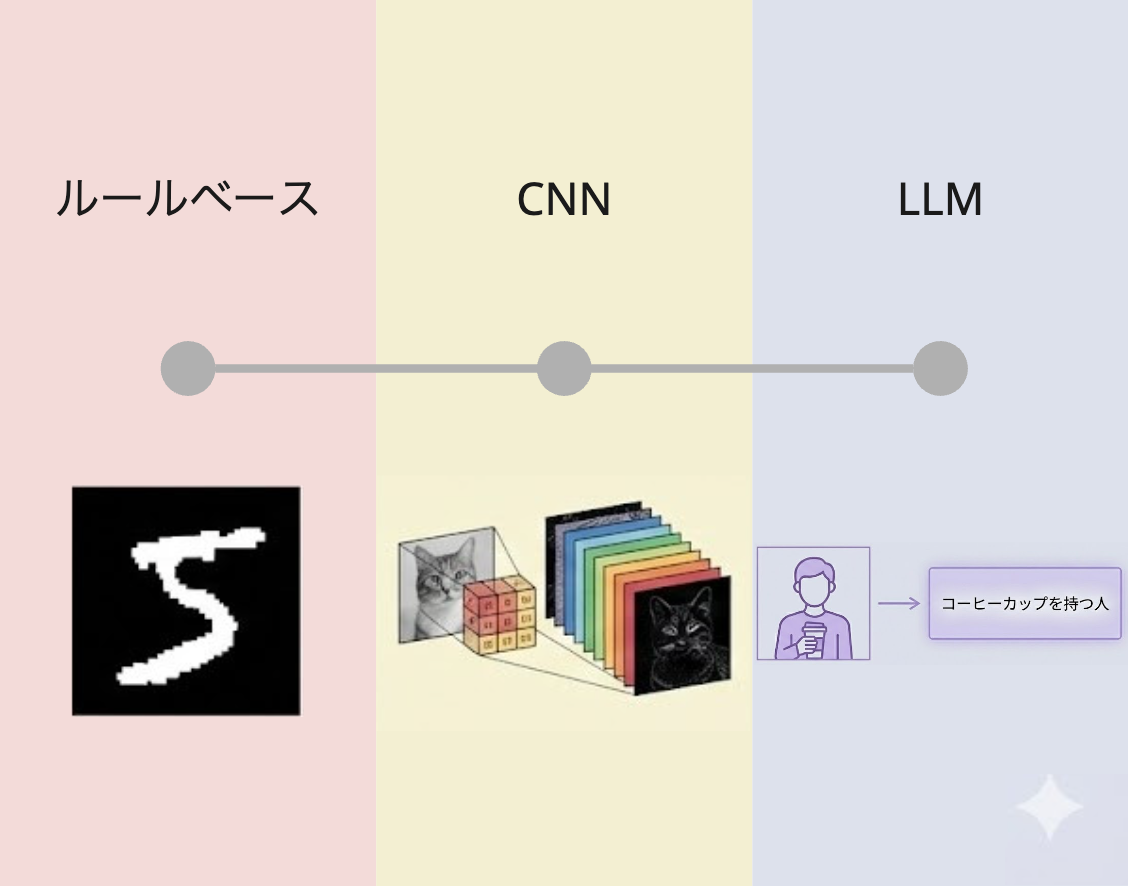

画像認識は大きく以下の3段階で進化してきました。

- ルールベース(従来画像処理)

- しきい値・エッジ・テンプレートマッチングなど

- 高速・決定論的・精密計測に強い

- ディープラーニング(CNN)

- 特徴量抽出が自動化

- ラベル付けデータに基づく高精度な分類・検出

- マルチモーダルLLM(GPT-5.1 / Gemini 3)

- ゼロショットで「意味理解」

- 文章で理由を説明できる

画像認識技術の変化のまとめ(Gemini 3 Proより作成)

1. ルールベース:厳密な「計測」と「判定」

まず初めに紹介するのが、クラシカルな技術であるルールベースです。

昔から画像処理ですが、今でも現場の主役です。

画像で表現される輝度値情報をもとに該当物の抽出や同じ検出対象物があるのか、長さなどの定量的な検品情報を計測するなど目視検査の代替となるような処理がメインとなります。

手法

- 基本処理:二値化、ブロブ解析、エッジ検出

- パターン検索:正規化相関、幾何学マッチング

- 特徴量活用:機械学習(SVMなど)

など

できること

- 精密計測:寸法測定、位置決め(サブピクセル単位の精度)

- 有無検査:部品の欠品、明確な異物の検出

- 特定形状の認識:登録したマークや形状の探索

など

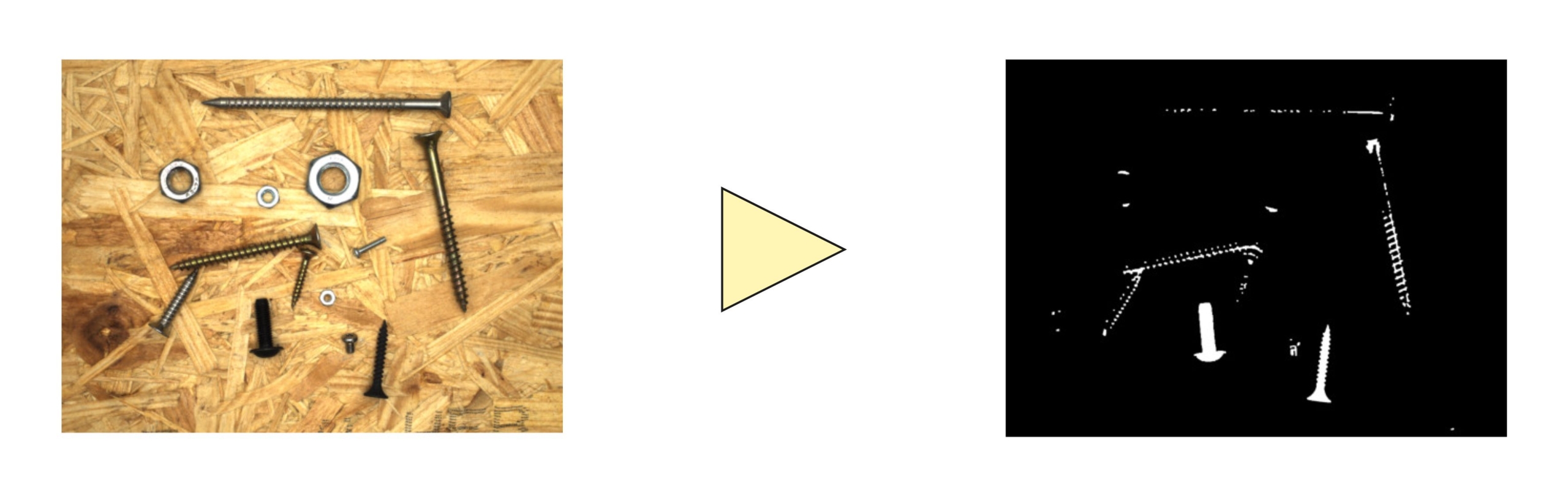

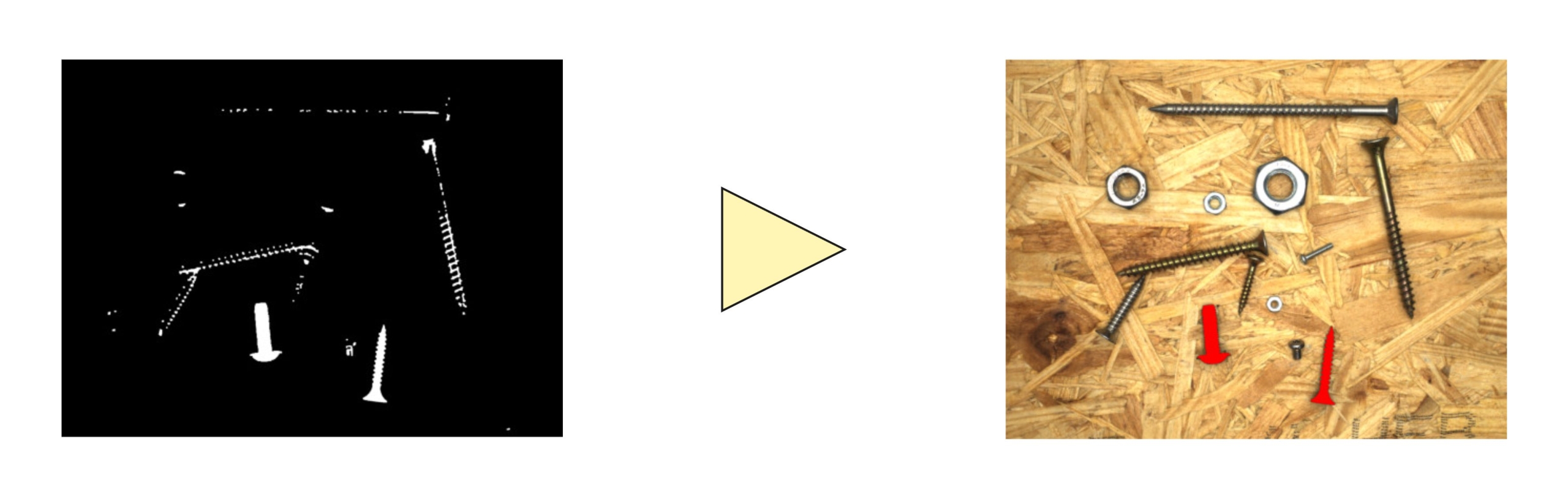

ここでは具体的な処理の例として、画像の中から「黒いネジ」だけを検出するケースを見てみましょう。 「ルールベース」という名前の通り、検出を行うためには人間が明確な判定ルールを定義する必要があります。今回は主に「二値化」と「ブロブ解析」という手法を用います。

ステップ1:二値化による抽出

まず、画像の色(輝度)情報をもとに「黒っぽい領域」をざっくりと抽出します。 以下の画像(Fig_03)は、二値化処理によって黒い部分を抽出し、白く表示させた結果です。

画像内の黒っぽいところを抽出した結果

ステップ2:ブロブ解析による選別

次に、抽出された領域(ブロブ)の中から、ネジの形状特徴に合致するものだけを選別します。

今回検出したい黒いネジは他のネジに比べて小さなネジであることから、特徴量の中でも面積に注目しました。 それぞれの面積の特徴量を抽出し、比較した結果、面積に対して以下のしきい値を設定しました。

面積(Area): 8000 ~ 15000 px

このルールを適用した結果、Fig_04のように目的の黒いネジだけを正確に検出(赤枠表示)することができました。

ブロブ解析した結果を赤く上乗りした結果

この例ではうまくいきましたが、もしここに「黒くて大きなネジ」が混ざっていたり、あるいは、照明が変わってネジの影が濃くなったりしたらどうなるでしょうか?その場合は、設定した「面積 8000〜15000 px」や二値化の基準から外れてしまい、検出できなくなります。

対象物の種類や環境が変わるたびに、人間の手によってしきい値を細かく調整し直さなければなりません。 これこそがルールベースの課題です。寸法計測や位置決めなど「答えが明確なタスク」では現在も主役ですが、人の目のように柔軟な判断が求められる検査には不向きです。

これらをまとめると、ルールベースには以下の課題があるといえます。

課題

- しきい値調整が困難:照明や個体差に合わせて、膨大なしきい値調整が必要。

- 環境変化に脆弱:外光、影、ワークの濡れなどで定状状態外に弱い。

- 定義困難な欠陥:「なんとなく変」「未知のキズ」は定義できないため検出不可。

2. ディープラーニング(CNN):「特徴抽出」の自動化

2015年頃から普及し始めた、いわゆる「AI外観検査」と呼ばれる技術の根幹がディープラーニング(以降CNN)です。

このパラメータの自動抽出技術によりこれまで人の手で行われてきた調整をネットワークアルゴリズムとして吸収することでルールベースでは苦手とされてきた環境変化に強い検出が可能となりました。

手法

- YOLO

- ResNet

- PatchCore

など

できること

- 特徴量の自動抽出:人手による定義ではなく、データから特徴を自動で学習・抽出

- 変動に強い高精度検出:位置ズレや回転に左右されず、対象物を高精度に認識

など

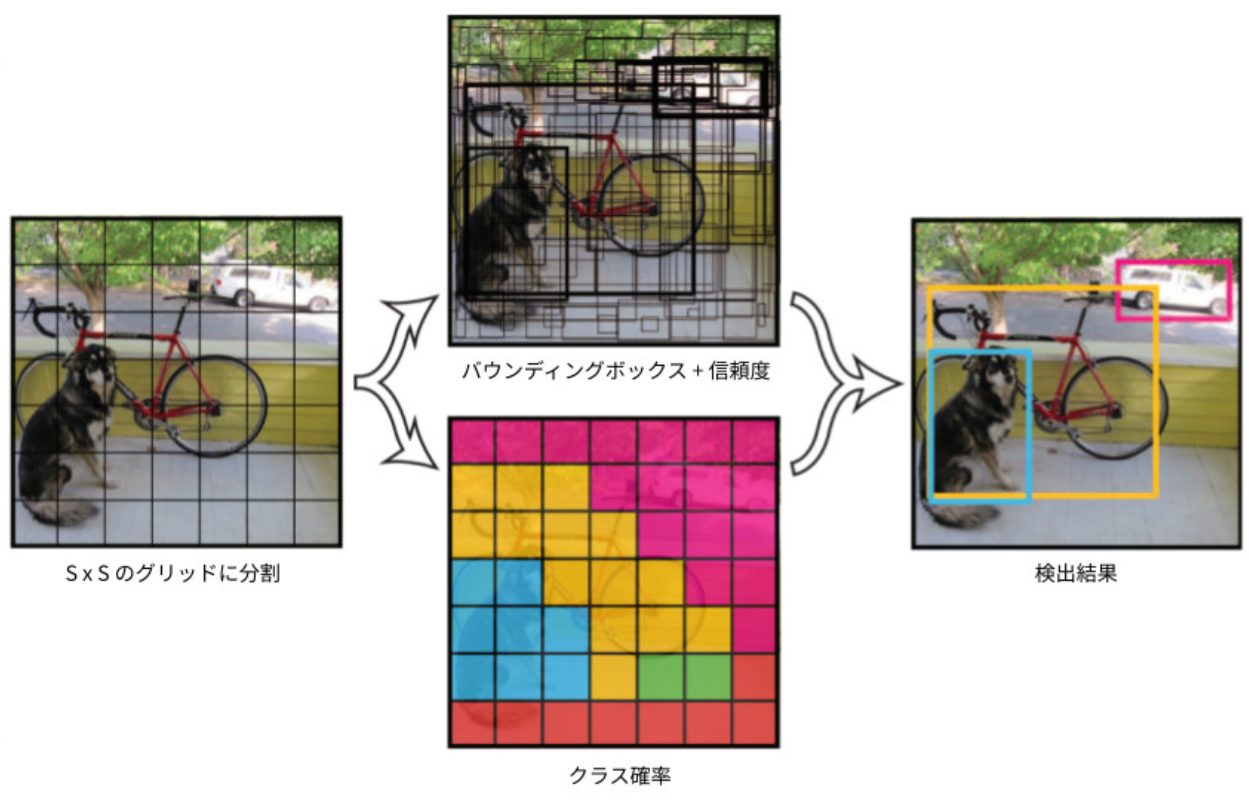

CNNのネットワークによって、具体的な内部処理が異なりますが、

下記画像ではYOLOでは入力された画像をグリッドごとに分割したのちに以下の2つの処理を実行します。

- 候補となる検知した物体を囲む枠とそれぞれの信頼度算出

- グリッドごとのクラス確率の算出

これら2つの結果から信頼度の高い結果を出力します。

詳しい実装についてはこちらの論文よりご参照ください。

YOLOのアルゴリズムについて

これにより、黒いネジ単体から、ネジとナット全体を含む検出へと適用範囲を広げることができました。 それに追加してルールベースの手法では難しかった、ネジの方向検知にも対応しています。

CNNによる検出結果例

そのため、外観検査においてはCNNが主流となりつつありますが、未知の欠陥が引き続き課題として以下の3つが残っていました。

課題

- 大量の不良データが必要: 高精度化には、多種多様な不良品画像の収集が不可欠。

- 微小欠陥(1 pxレベル)の検出: 畳み込みによる圧縮処理で、微細な情報が消失する可能性がある。

- 大局的な意味理解の苦手さ: 局所特徴には強いが、全体構造や関係性の把握は苦手。

3. マルチモーダルLLM:「意味理解」と「推論」の時代へ

そして2025年12月。GPT-5.1やGemini 3の登場により、AIは画像を見て「文章で説明する」能力を獲得しました。

この技術革新は、画像認識のアウトプットを根底から変えました。単なる「有無確認」や「良品判定」といったバイナリな出力に留まらず、LLM自身が対象物の意味を理解し、解釈できるようになったのです。これにより、大きく2つの変化が起きました。

- ルールベースのように、ネジなどの部品ごとに特徴を厳密に定義する必要はありません。プロンプト(自然言語)で指示するだけで、即座に検出が可能となりました。

- 人の思考に近い柔軟な状況判断が可能になったため、その活躍の場は製造業の枠を超えました。商業施設での防犯、街中の見守り、交通状況の把握など、監視カメラが設置されたあらゆる空間でその真価を発揮します。「カメラの目」がある場所であればどこでも、高度な意味解析が可能となったのです。

手法

- GPT-5.1

- Gemini 3

など

できること

- 意味・文脈の理解:画像の持つ「意味」や「意図」の解釈、状況の推論

- 未知・非定型の認識:ゼロショットによる未知対象の検出、事前定義不要な柔軟性

- 判断根拠の言語化:単なる判定ではなく、不良に至った「理由」の文章化

など

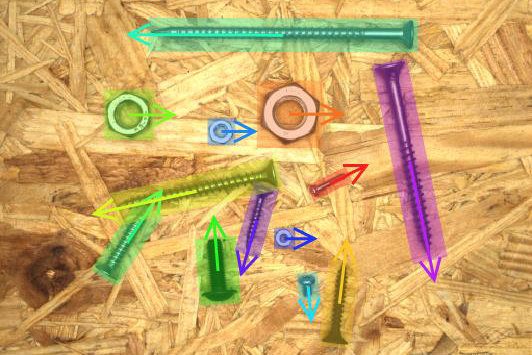

これまで処理を行っていた画像に下記のプロンプトを入力したところ、以下のようにネジだけの検出を行うことができました。

使用LLM:Gemini 3

入力プロンプト

以下の画像について、「ネジ(screw)」をすべて検出してください。

目的:

- ネジの位置(bounding box)

- ネジの本数

- ネジと判断した根拠(誤検出防止の理由)

入力画像情報:

- 高さ(height):1920 px

- 幅(width):1440 px

出力要件(厳密):

1. バウンディングボックスは次の形式で返すこと:

{ "x_min": int, "y_min": int, "x_max": int, "y_max": int }

2. 座標値は入力画像サイズ(1440×1920)に合わせた **整数 (int)** で返すこと。

3. ネジの種類は必ず以下の分類から選択すること:

- screw

- other(分類不能)

4. 出力形式は JSON のみとすること。

5. 信頼度(confidence)は 0〜1 に正規化した浮動小数で返すこと。

6. **検出したバウンディングボックスを描画した画像を、モデルが返せる形で出力すること。**

- bounding box と type を画像上に描画すること。

- 出力形式は base64 PNG またはモデルが対応可能な画像出力形式でよい。

出力フォーマット(厳密):

{

"screw_count": n,

"screws": [

{

"id": 1,

"type": "screw_phillips",

"bbox": { "x_min": 0, "y_min": 0, "x_max": 0, "y_max": 0 },

"confidence": 0.0,

"reason": "ネジであると判断した理由を明確に記述"

}

],

"annotated_image": ""

}

注意事項:

- ネジではない穴・汚れ・リベット・ジョイントパーツは誤検出しないこと。

- ネジと判断した場合は形状、溝、頭部の特徴など「理由」を必ず書くこと。

- 種類分類が困難な場合は screw_other とすること。

出力結果

{

"screw_count": 7,

"screws": [

{

"id": 1,

"type": "screw",

"bbox": {

"x_min": 1022,

"y_min": 384,

"x_max": 1166,

"y_max": 1325

},

"confidence": 0.99,

"reason": "長い木工用ネジ。黄色亜鉛メッキ、皿頭、螺旋状のネジ山、鋭い先端を確認。"

},

{

"id": 2,

"type": "screw",

"bbox": {

"x_min": 317,

"y_min": 864,

"x_max": 734,

"y_max": 1075

},

"confidence": 0.98,

"reason": "木工用ネジ。黄色亜鉛メッキ、皿頭、螺旋状のネジ山。水平方向に配置されている。"

},

{

"id": 3,

"type": "screw",

"bbox": {

"x_min": 648,

"y_min": 979,

"x_max": 734,

"y_max": 1306

},

"confidence": 0.96,

"reason": "小型の木工用ネジ。金色、皿頭、螺旋状のネジ山、鋭い先端を確認。"

},

{

"id": 4,

"type": "screw",

"bbox": {

"x_min": 259,

"y_min": 1094,

"x_max": 418,

"y_max": 1440

},

"confidence": 0.97,

"reason": "銀色のタッピングネジ。なべ頭、螺旋状のネジ山、鋭い先端を確認。"

},

{

"id": 5,

"type": "screw",

"bbox": {

"x_min": 547,

"y_min": 1229,

"x_max": 634,

"y_max": 1555

},

"confidence": 0.95,

"reason": "黒色のボルト(小ネジ)。平頭、六角穴付き、細かいネジ山(マシンネジ)を確認。"

},

{

"id": 6,

"type": "screw",

"bbox": {

"x_min": 806,

"y_min": 941,

"x_max": 864,

"y_max": 1056

},

"confidence": 0.92,

"reason": "極小の銀色小ネジ。なべ頭、細かいネジ山を確認。"

},

{

"id": 7,

"type": "screw",

"bbox": {

"x_min": 864,

"y_min": 1344,

"x_max": 950,

"y_max": 1747

},

"confidence": 0.98,

"reason": "黒色のコーススレッド(ドライウォールスクリュー)。ラッパ頭、粗い螺旋状のネジ山、鋭い先端を確認。"

}

],

"annotated_image":"

}

このように学習をせずともネジの検出が可能な点はかなり強力です。

ただし、LLM固有の非決定論性があること、FAで求められるタクトタイムを大きく上回ることからそのままの導入はされないと考えています。

課題

- 処理速度の課題:推論に時間を要するため、100ms以内といった高速なタクトタイムへの追従が困難。

- 回答の非決定性:確率的な挙動により、同一画像に対しても出力が揺らぐため、完全な再現性の担保が難しい。

- 品質保証の障壁:ハルシネーションのリスクがあり、厳格な安全性・品質保証への適合が困難。

それぞれの手法の棲み分け

ここまで紹介してきた 3 つの手法(ルールベース / CNN / マルチモーダルLLM)について、主要観点を整理した比較表を以下にまとめます。

| 観点 | 従来ルールベース | CNN | マルチモーダルLLM |

| 速度 | ◎ (ms単位) | 〇 (数ms〜数十ms) | △〜× (100ms〜秒単位) |

| 再現性 | ◎ (決定論的) | ◎ (決定論的) | △ (非決定論的・揺らぎあり) |

| 新規/未知不良 | × (事前学習・定義が必要) | △ (大量の学習データが必要) | ◎ (ゼロショットで対応) |

| 説明性 | △ (数値のみ) | △ (ヒートマップ箇所のみ) | ◎ (自然言語で理由を説明) |

| コスト | △ (開発工数・調整費が大) | △ (アノテーション・学習コスト大) | 〇 (API利用で初期導入は容易) |

| 実装難易度 | △ (専門知識が必要) | △ (データ準備・モデル選定要) | ◎ (プロンプトと数行のコード) |

それぞれの手法には強みが分かれているため、どれか一つの技術ですべてを賄うのではなく、タスクの性質に応じた「役割分担」が重要であると考えています。

さいごに

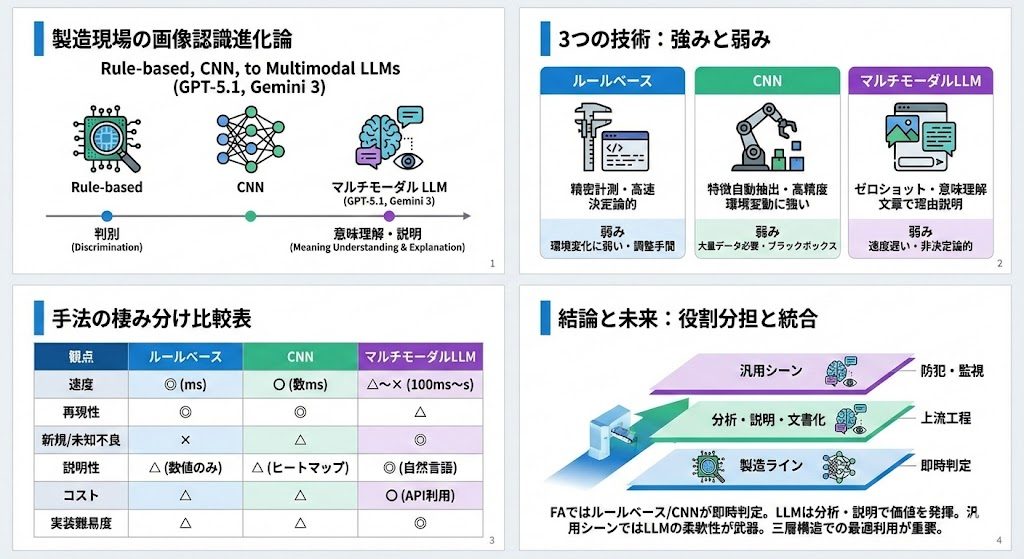

本記事では、画像認識技術の進化と、近年急速に存在感を増すマルチモーダルLLMについて整理しました。

ルールベース、CNN、そしてマルチモーダルLLM。これら三つの技術は競合するものではなく、用途に応じて役割を分担する存在です。

FAが求める高速性・決定論性・100%の再現性を踏まえると、少なくとも現時点ではマルチモーダルLLMが製造ライン上の即時判定を代替する未来はまだ遠いと思われます。

むしろ、FAではこれまで通りルールベースとCNN が“ライン上の即時判断”を担い、マルチモーダルLLMは分析・説明・文書化・未知パターンの解釈”といった上流工程で価値を発揮していくでしょう。

一方で、製造業ほど厳密な制約がない領域、たとえば防犯カメラ・監視システム・現場の映像解析といった“汎用シーン”では、マルチモーダルLLM の柔軟性が大きな武器となり、人物・行動・意図の説明、複雑な状況判断など、これまでの画像認識では難しかった高度な認識タスクが現実的になりつつあります。

今後は、ルールベース(精密) × CNN(外観) × マルチモーダル LLM(意味理解) の三層構造で、利用シーンごとに最適な技術を選び取ることがより重要になると考えます。

他実例

ここまで、画像認識技術の進化とマルチモーダルLLMの可能性について解説してきました。 マルチモーダルAIは、画像を「認識」するだけでなく、テキストの内容を理解して新たな画像を「生成」する能力も飛躍的に発展させています。

本記事の締めくくりとして、マルチモーダルLLM自身に、今回の解説内容の要点をまとめたスライド形式の画像を生成させました。これまでの内容を視覚的に整理するまとめとしてご覧ください。

本記事のまとめ画像(Gemini 3 Proより作成)

参考資料

- Markus Ulrich, Patrick Follmann, Jan-Hendrik Neudeck: A comparison of shape-based matching with deep-learning-based object detection; in: Technisches Messen, 2019, DOI 10.1515/teme-2019-0076.

用語集

FA・現場関連

- OCR

- 正式名称: Optical Character Recognition(光学的文字認識)

- 画像の中から文字を探し出し、テキストデータとして読み取る技術。製造現場では、部品の型番読み取りや賞味期限の確認などで使用される。

AI・アルゴリズム関連

- CNN

- 正式名称: Convolutional Neural Network(畳み込みニューラルネットワーク)

- ディープラーニングの一種で、画像認識に特化したモデル構造。画像の特徴(形状や模様など)を自動で抽出することに長けており、現在の外観検査AIの主流技術。

- SVM

- 正式名称: Support Vector Machine(サポートベクターマシン)

- ルールベース手法の時代から使われている古典的な機械学習アルゴリズムの一つ。人間が決めた特徴量(面積や長さなど)を元に、境界線を引いてデータを分類する手法。

- YOLO

- 正式名称: You Only Look Once

- ディープラーニングを用いた物体検出アルゴリズムの一つ。「画像を一回見るだけ」で処理が完了するという名の通り、処理速度が非常に速く、リアルタイム性が求められる現場で人気がある。

開発・データ関連

- API

- 正式名称: Application Programming Interface

- ソフトウェアや機能(ここではGPTやGeminiなどのAIモデル)を、外部のプログラムから利用するための接続窓口。これを利用することで、自社で巨大なサーバーを持たずに高性能なAI機能をシステムに組み込める。

- JSON

- 正式名称: JavaScript Object Notation

- データ記述形式の一つ。人間にも機械にも読みやすいテキスト形式で、AIが出力した検出結果(座標や個数、判定理由など)をシステム間で受け渡す際によく利用される。